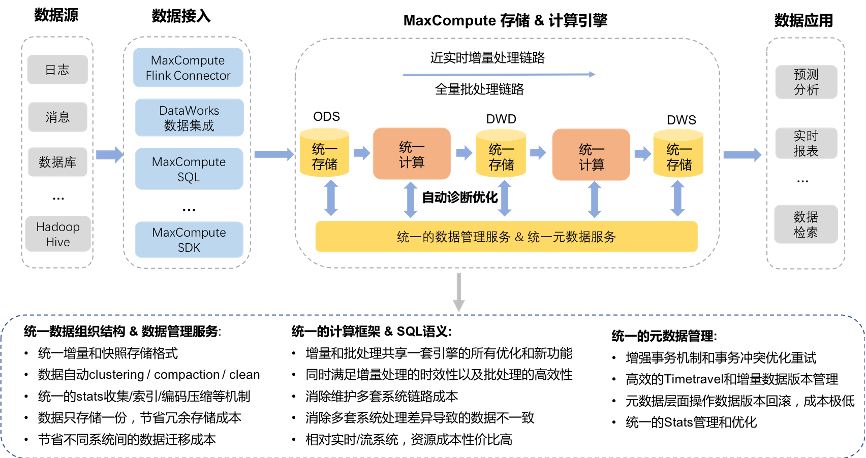

隨著大數據技術的演進,企業對數據處理時效性的要求日益提升,傳統T+1的批處理模式已難以滿足實時分析與決策的需求。阿里云MaxCompute作為領先的大數據計算平臺,積極擁抱湖倉一體架構,并融合近實時增量處理能力,構建了一套高效、穩定且靈活的數據處理與存儲支持服務體系,為企業數字化轉型注入了新動力。

一、 核心理念:湖倉一體的融合與演進

MaxCompute的湖倉一體架構并非簡單地將數據湖與數據倉庫疊加,而是通過深度整合,實現了兩者的優勢互補。其核心在于:

- 統一存儲層:以開放格式(如Parquet、ORC)存儲數據,支持對存儲在對象存儲(OSS)等上的數據直接進行分析,打破了數據孤島,實現了數據在湖與倉之間的自由流動與統一管理。

- 統一元數據與權限:提供統一的元數據服務和細粒度的數據安全與權限管控,確保數據在湖、倉以及不同計算引擎間訪問的一致性、安全性與可治理性。

- 統一計算引擎:MaxCompute SQL、Spark、Flink等多種計算引擎可無縫對接同一份數據,根據場景選擇最合適的處理模式,從批量ETL到交互式查詢,再到流處理,實現計算范式的統一。

二、 近實時增量處理的技術架構

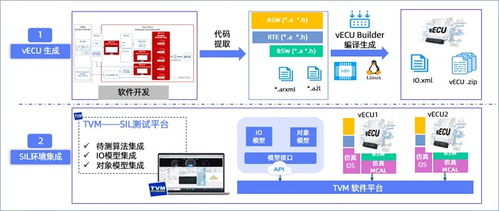

為應對分鐘級甚至秒級延遲的數據處理需求,MaxCompute在湖倉一體基礎上,構建了高效的近實時增量處理技術棧。

1. 增量數據高速攝入通道

- 數據源對接:無縫集成數據庫Binlog(如MySQL)、消息隊列(如Kafka、RocketMQ)、日志文件等多種實時數據源。

- 流式攝入服務:通過Flink CDC、DataHub等組件,以極低的延遲將增量數據持續、穩定地攝入到MaxCompute的存儲層,并保證數據的Exactly-Once語義和順序性。

2. 增量存儲與表格式

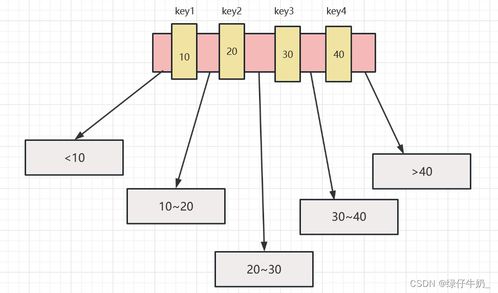

- 增量文件組織:采用如Hudi、Iceberg等開源表格式或自研優化格式來管理數據。這些格式支持增量文件的快速追加、小文件合并、ACID事務以及時間旅行查詢,是近實時處理的基石。

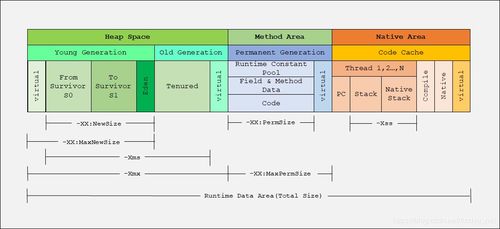

- 分層存儲與生命周期管理:熱數據(最新增量)與溫冷數據采用不同的存儲介質和壓縮策略,在保證查詢性能的同時優化存儲成本。系統自動管理數據生命周期,完成從實時層到明細層、匯總層的平滑流轉。

3. 近實時計算與同步

- 微批與流計算融合:核心在于“微批”(Micro-batch)處理模式。系統以固定的短周期(如1-5分鐘)調度處理任務,對上一個周期內到達的增量數據進行計算。這既保證了較低的端到端延遲,又繼承了批處理框架的容錯性和狀態管理優勢。

- 增量物化視圖與聚合:支持創建基于增量數據的物化視圖,系統自動維護視圖的刷新,使得下游應用能夠近乎實時地查詢到最新的聚合結果,極大提升了寬表構建和指標計算的效率。

- Lambda架構簡化:通過一套架構同時處理實時流和離線歷史數據,避免了維護兩套系統(流、批)的復雜性,實現了架構的簡化和數據的一致性。

4. 統一服務與數據輸出

- 一體化查詢服務:通過MaxCompute SQL或兼容Spark SQL的接口,用戶可以透明地查詢包括最新增量在內的全量數據,無需感知底層是實時數據還是歷史數據。

- 多模數據服務:處理后的數據可靈活地輸出至各類服務,如同步至OLAP數據庫(如Hologres、ADB)供交互式分析,推送至緩存或消息隊列供在線服務調用,或直接以文件形式供數據科學平臺使用。

三、 數據處理與存儲支持服務全景

MaxCompute圍繞上述架構,提供了一站式的數據處理與存儲支持服務:

- 彈性可擴展的計算與存儲:計算與存儲資源徹底解耦,均可獨立彈性伸縮,從容應對業務峰值,并實現成本最優。

- 企業級可靠性與運維:提供高達99.95%的可用性SLA,具備跨可用區容災、數據多重備份、自動故障恢復等能力,并配備完善的監控、告警與智能運維工具,降低運維負擔。

- 全鏈路數據治理:內置數據質量、數據地圖、數據血緣、成本優化等治理工具,確保從數據攝入、處理到服務全鏈路的可靠性、可追溯性與成本可控性。

- 開放生態集成:與阿里云DataWorks(數據開發與治理)、Flink、OSS等產品深度集成,同時兼容開源生態,保障用戶技術棧的平滑過渡與擴展。

###

MaxCompute的湖倉一體近實時增量處理架構,代表了大數據平臺向實時化、智能化、一體化演進的重要方向。它通過統一存儲、統一計算、統一服務,不僅解決了數據時效性的核心痛點,更簡化了架構,降低了運維復雜度,為企業構建實時數據倉庫、進行實時監控預警、實現用戶實時畫像等場景提供了堅實的技術基礎。隨著技術的持續迭代,這一架構將助力更多企業在數據驅動的道路上跑出“加速度”。